声音克隆+视频通话,豆包猜出了我住哪个小区

作者|小金牙 来源|直面AI(ID:faceaibang)

豆包的新功能,大家都试了吗?

在最新版的豆包APP里,已经有“视频通话”的功能。

也就是说,你现在可以打开摄像头,让豆包直接“看”了。

我测试的时候,豆包不仅一眼看出我家龟背竹是仿真的假货,还通过窗景猜出了我家小区的名字,真是刺激。

目前,“视频通话”已经是各家AI厂商争相上线的功能:OpenAI的ChatGPT、谷歌的Gemini,以及国内的智谱等,都已经让AI“开眼”。腾讯紧紧跟上,预计下周就会在元宝中看到类似功能。

别忘了,下一代硬件的寻找和创造,正在世界范围里上演。当我们不再需要举起摄像头,视频通话还会带来更多想象力。

01

“视频通话”,相当于豆包有了眼睛

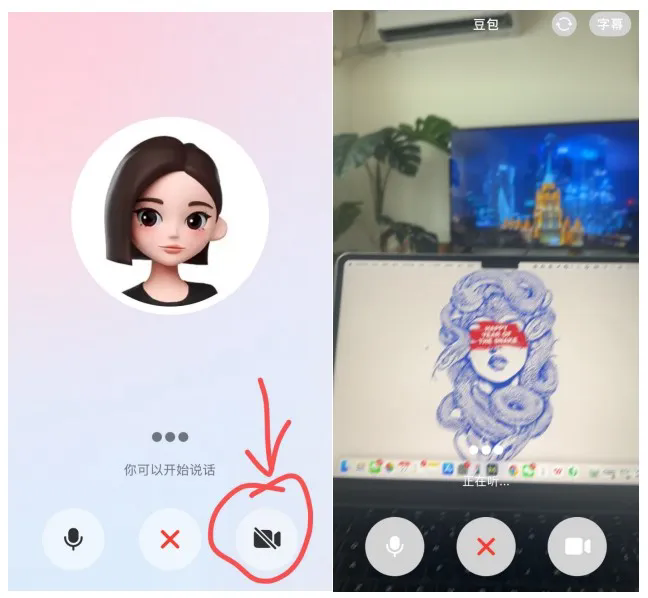

豆包的视频通话入口在“打电话”里,只不过从前点击通话,仅有语音通话的功能,现在出现了一个摄像机按钮。实际体验下来,这样的安排符合使用逻辑。

点击按钮,画面上出现你手机镜头拍摄的实时画面。

所以要注意的是,和豆包视频通话,与和人视频通话有很大区别,不是说豆包作为一个虚拟形象和你面对面,而只会有你单方面的视频画面。更像是在给豆包做一对一的视频直播,或者说邀请豆包通过你的摄像头看你的世界。

我们进行了以下测试:

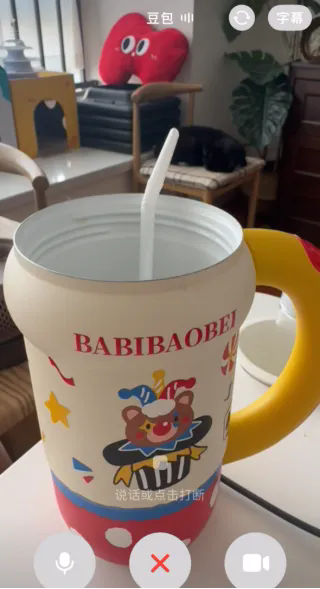

第一,这是什么?

作为热身项目,先测试一下豆包对各种事物的判断是否准确。

摄像头打开后,豆包主动发言,描述我正坐在电脑前,后方的电视正在播放美剧。

对家具、电器等的判断没有难度,轻松回答。令人惊讶的是以下三件:

在刻意摇晃镜头的情况下,一个看起来是大马克杯的保温杯,一盆(很多来我家的朋友都以为是真植物的)仿真龟背竹,在猫窝里只露出两只脚和尾巴(且堆叠在一起)的橘猫,豆包都回答正确。

第二,我在哪儿?

判断物品没问题,我试图将豆包带到更有挑战的场景里。

镜头对准窗外,让豆包帮我看看我在哪里。豆包先是根据街景和绿化度,给出了三个城市的名称,其中包括正确答案,另外两个城市也距离很近。接着看到了路牌上的街名,这条街道非常长,有几公里,但是豆包准确说出了我所在的小区的名字。

第三,这怎么用?

接下来是一个日常的“有用”场景,让豆包教我使用电器。

镜头对准一个小电器,豆包准确判断这是一款“胶囊咖啡机”。我随后便问“胶囊是什么”边用镜头快速扫过桌面,它用很自然的语言告诉我:“就在那儿啊,一个米色袋子里”。

随后,豆包又指导我将胶囊放入咖啡机并按下按钮,在我表示按了按钮没反应后,又指导我检查水箱。全程豆包并非机械式地“背诵使用说明”,而是根据看到的画面进行指导,比如“机器后方的两个黑色按钮”“把机器侧一下,我看看水箱在哪里”“就是后面带刻度、塑料的那个”。

整个过程非常丝滑、自然。

第四,我该买点啥?

很多人已经在用AI辅助减肥,比如制定饮食、健身计划,但是人嘛,自述情况很有可能有偏差,要是直接让AI看呢?

打开冰箱,让豆包猜猜我的饮食习惯,并给出采购建议。豆包准确总结我的食物种类很多,肉食和速冻食品比较多,建议我购买绿叶蔬菜。可以说是一针见血了。

几个简单的测试走下来,可以看出豆包可以透过镜头,颇为准确地判断看到的事物,并且和用户产生实时的互动。这提供了很多想象力,如在旅游时提供帮助、在采购时提供建议、教用户使用物品等。

02

视频通话仍摆脱不了“AI味儿”

特别要指出的一点是,豆包在视频通话时,语言平实,表达方式生活化、口语化,不会有很机械、死板的感受,这非常重要。

顺便推荐一个“进阶”玩法:豆包语音克隆+视频通话。语音克隆的功能已经在豆包里很久了,用户不仅可以选择豆包提供的预设音色,还可以通过简单的步骤获得克隆的音色。

我的豆包里一直用的是姐姐的克隆音,豆包在视频通话中的语言又非常日常,也因此,视频通话时真的有一种在和我姐打视频的错觉。

不敢想象如果我给我妈的豆包安排一个我的克隆音,再教会她怎么视频通话,她会有多爱用。

我们也同步测试了ChatGPT,在视频通话模式下,二者的准确度都很高。但是ChatGPT没有看出彩色马克杯实际上是一个保温杯,进一步追问才给出判断,且在“看窗景猜地点”的小测中,ChatGPT的回答离正确答案差得很远。

另外很明显的感受是,ChatGPT在视频通话模式下的表达方式“更AI”,措辞比较书面化,不确定使用英文的话,ChatGPT会不会更自然一些。

但也不是没有遗憾,目前豆包视频通话还是要“等一下”AI的回复。而且有时候可能是问题比较难回答,“思考”时间会更长一些,经常出现以为AI卡住了,结果和AI一起开口的情况。

另一个遗憾是,在视频通话中,依然遵循用户说话、AI回答的模式。在实际体验中,豆包会在自己的句尾主动和用户互动,比如“你在看《无耻之徒》吗”,但是它做不到“主动出击”。

如当我告诉豆包,我现在要打字,当看到“2”的时候立刻告诉我。虽然豆包欣然答应,但是它并不会在看到“2”的时候立刻指出,而是必须等我询问,它再回答。同样地,对“看到扫地机器人就立刻告诉我”的请求,它也同样无法做到。它的确看到了机器人,但是需要等我再说一句话,才轮到它发言。

当然,这些不仅是豆包视频通话的遗憾,ChatGPT也是同理。和已经普及的“语音通话”一样,AI依然需要遵循既定的对话模式,而非像人与人沟通时那般灵活。

03

AI交互方式再次迭代

“视频通话”可以带来很多想象力,尤其是在如今“AI代理”成为风口、“超级AI助理”成为桂冠上的明珠之时。

豆包此次的升级基于“豆包·视觉理解模型”。该模型去年年底发布,此后又经历了升级,同时具备内容识别能力、理解和推理能力以及更细腻的视觉描述能力。

从2022年底ChatGPT横空出世之后,我们与AI的交互方式已经不断进化:纯文本交互(你打字给AI,AI也回复文字)、实时语音交互(直接和AI说话,AI也用声音回复)、图像交互(你发给AI一张图片或视频,AI可以解读)、实时图像交互(视频通话)。

能直接打开摄像头,让AI自己“看”,直接邀请AI“进入”所处的世界,相当于揭开了我们和AI之间始终隔着的一层名为“描述”的薄纱。从实际体验来说,在视频通话时,AI的“Agent”属性更加凸显,而非一个手机里的小小工具。

去年12月,OpenAI就给ChatGPT加入了视频通话的功能,谷歌的项目Project Astra也已经启动。在国内,包括智谱在内的头部AI玩家也已经配上了视频通话。此外,就在上周,腾讯旗下语音通话模型Hunyuan-Voice宣布将于6月登陆元宝APP,直接对标字节跳动旗下豆包AI的视频通话功能。

让AI“开眼”,已经越来越普遍。

对此,前不久在谷歌I/O开发者大会上,谷歌DeepMind创始人兼CEO戴密斯·哈萨比斯(Demis Hassabis)称,他们将Gemini打造成一个世界模型,是开发一种新型、更通用、更有用AI助手的关键一步。

这家巨头目标直接指向构建通用AI助手。大会上宣布,Gemini Live正式向 iOS 和安卓用户开放。这项功能可以实时识别并回应用户手机摄像头和屏幕上的内容。

更值得注意的是,Gemini Live是Project Astra的延伸,而后者也在大会上展示了新的进展:更主动。比如AI“看”着用户做题,在发现错误的时候会直接指出。

这也对应了在使用现有AI视频通话功能时的那个困扰,即虽然AI已经看到了某个物品,但仍然要“用户一句,它一句”,等着轮到自己发言。

而以上讨论还仅限于手机这个核心硬件。但未来的“AI硬件”未必还会是手机,如果下一代硬件比手机更小巧、更灵活,那视频通话的能力还会发挥更大潜力。

比如如今已经被AI厂商积极尝试的XR眼镜,通过这个设备“观察”世界,不需要用户举起手机。可以想象,如果你戴着一副AR眼镜,打开摄像头,AI将可以更“无形”地提供帮助(甚至只是陪伴)。

随处可见“自言自语”的人类,这样的未来也许已经不远了。

编者按:本文转载自微信公众号:直面AI(ID:faceaibang),作者:小金牙

品牌、内容合作请点这里:寻求合作 ››

前瞻经济学人

专注于中国各行业市场分析、未来发展趋势等。扫一扫立即关注。